این روزها که ابزارهای هوش مصنوعی پایشان به همه نوع کسبوکاری باز شده، یک سوال اساسی پیش میآید: آیا همان سرورهای معمولی کارمان را راه میاندازند یا وقتش رسیده که سراغ سرور اختصاصی هوش مصنوعی (AI Server) برویم؟

فرقی نمیکند در حال توسعه اپلیکیشن باشید، مشغول تحلیل دادههای سنگین، و یا مدیری که میخواهد ببیند هوش مصنوعی چه کمکی به رشد کسبوکارش میکند؛ این راهنما دقیقاً برای شماست. در اینجا بررسی میکنیم که سرور هوش مصنوعی چیست، چرا اهمیت دارد و چطور باید تصمیم بگیرید که آیا سرمایهگذاری روی آن برای شما توجیه اقتصادی دارد یا نه.

مقدمه

ورود هوش مصنوعی به دنیای تجارت را میتوان به وضوح در همهجا دید؛ از چتباتها و سیستمهای اتوماسیون گرفته تا پیشبینی بازار، تشخیص تصویر و تحلیل لحظهای دادهها. اما نکته اینجاست که سرورهای اشتراکیِ قدیمی و معمولی که برای میزبانی وبسایتها یا کارهای ساده استفاده میشوند، زورشان به پردازشهای سنگین این ابزارهای مدرن نمیرسد.

به زبان ساده، سرور هوش مصنوعی یک کامپیوتر اختصاصی و بسیار قدرتمند است که دقیقاً برای انجام کارهای سنگین و پرمصرف، مثل آموزش (Training) یا اجرای مدلهای هوش مصنوعی طراحی شده است. این پردازشها نیاز به توان محاسباتی بالا، حافظه (RAM) بسیار زیاد و سختافزارهای تخصصی دارند که در سرورهای معمولی پیدا نمیشوند.

ابزارهای هوش مصنوعی عملاً زمین بازی را در بسیاری از صنایع تغییر داده و فرصتهای برابری ایجاد کردهاند. دیگر فرقی نمیکند یک هلدینگ بزرگ باشید یا صاحب یک کسبوکار کوچک، متخصص IT و فریلنسر باشید یا یک آژانس خلاق؛ امروزه استفاده از ابزارهای AI برای بالا بردن راندمان و خودکار کردن کارهای تکراری، به یک استاندارد و ضرورت تبدیل شده است.

بیایید برویم سر اصل مطلب و ببینیم سرور هوش مصنوعی دقیقاً چیست، چه تفاوتهایی با یک سرور معمولی دارد و معمولاً کجا نگهداری میشود.

چکیده و نکات کلیدی

- سرورهای هوش مصنوعی دقیقاً برای آن دسته از پردازشهای سنگین و نفسگیر (مثل آموزش مدلها و استنتاج) ساخته شدهاند که سرورهای استاندارد و معمولی اصلاً توان انجامش را ندارند.

- این سیستمها برای ارائه نهایتِ سرعت، از ترکیب شتابدهندههای قدرتمندی مثل GPU و TPU در کنار حافظههایی با پهنای باند بالا و درایوهای پرسرعت NVMe استفاده میکنند.

- اگر کسبوکارتان نیاز به پردازشهای لحظهای (Real-time) دارد، روی مدلهای اختصاصی کار میکنید یا محرمانگی دادهها برایتان حیاتی است، زیرساخت اختصاصی هوش مصنوعی سرعتی بالاتر و کنترلی کاملتر را در اختیارتان میگذارد.

- اینکه سراغ راهکارهای ابری (Cloud) بروید، سرور فیزیکی (On-prem) بگیرید یا ترکیبی کار کنید، کاملاً به بودجه، حساسیت کارتان به تأخیر (Latency) و حجم کاریتان بستگی دارد.

- اولتاهاست (UltaHost) مسیر ورود به این دنیا را برای تیمها هموار کرده است. با ارائه پلتفرمهای آماده GPU و میزبانی NVMe پرسرعت، میتوانید بدون دردسرهای فنی و هزینههای سنگین خرید سختافزار، با قیمتی منطقی از قدرت هوش مصنوعی استفاده کنید.

سرور هوش مصنوعی چیست؟

سرور هوش مصنوعی (AI Server) سیستمی است که از پایه و اساس برای اجرای سنگینترین پردازشهای هوش مصنوعی مهندسی شده است. کار این سرورها مثل سرورهای معمولی، میزبانی سایت یا اجرای اپلیکیشنهای ساده نیست؛ بلکه تخصصشان در آموزش مدلها، تحلیلهای لحظهای و مدیریت حجم عظیمی از دادههاست که سرورهای معمولی زیر بار آن کمر خم میکنند. در واقع، این سرورها برای پردازش موازی طراحی شدهاند تا بتوانند چندین کار پیچیده را همزمان انجام دهند.

تفاوت اصلی اینجاست: سرورهای سنتی مثل کامپیوترهای خانگی عمدتاً متکی به پردازنده مرکزی (CPU) هستند، اما سرورهای هوش مصنوعی به شتابدهندههای سختافزاری قدرتمندی مثل GPU، TPU یا FPGA مجهز شدهاند تا بتوانند از پسِ پردازش دادههای غولپیکر برآیند.

علاوه بر این، این سرورها به حافظه (RAM) با پهنای باند بسیار بالا، هاردهای فوقسریع و شبکه پیشرفته مجهز شدهاند تا هیچ گلوگاهی در انتقال دادههای مورد نیاز مدلهای هوش مصنوعی ایجاد نشود.

همین معماری خاص باعث شده تا سرورهای AI بهترین گزینه برای کارهای زیر باشند:

- آموزش و تِرین کردن مدلهای بزرگ یادگیری ماشین.

- راهاندازی چتباتها و دستیارهای هوشمندی که باید در لحظه (Real-time) پاسخگو باشند.

- پردازشهای سنگین و گروهی روی تصاویر و ویدیوها.

- پیادهسازی هوش مصنوعی در لبه شبکه (Edge) برای جاهایی که سرعت پاسخگویی حیاتی است.

خلاصه کلام اینکه سرور هوش مصنوعی فقط یک کامپیوتر «سریعتر» نیست؛ بلکه یک اکوسیستم محاسباتی تخصصی است که تکتک اجزای آن برای نیازهای دنیای مدرن هوش مصنوعی بهینهسازی شده است.

مقایسه فنی: سرور معمولی در مقابل سرور AI

| ویژگی | سرور استاندارد | سرور هوش مصنوعی |

| کاربرد اصلی | وبسایتها، اپلیکیشنها | آموزش هوش مصنوعی، استنتاج (Inference)، پردازشهای دادهمحور سنگین |

| هسته پردازشی | فقط CPU | ترکیب CPU با GPU / TPU / FPGA |

| حافظه (RAM) | متوسط | بسیار بالا |

| شبکه | SSD استاندارد | حافظه پرسرعت NVMe + مناسب برای دیتاستهای حجیم |

| زیرساخت شبکه | پهنای باند معمولی | پرسرعت، با تأخیر (Latency) پایین |

| نوع ورکلود (Workload) | میزبانی وب، برنامههای تجاری | چتباتها، هوش مصنوعی مولد (Generative AI)، بینایی ماشین، آموزش مدل |

موارد استفاده رایج سرورهای هوش مصنوعی

سرورهای هوش مصنوعی دیگر فقط مختص غولهای فناوری نیستند. با ادغام روزافزون راهکارهای هوش مصنوعی در محصولات و خدمات پرکاربرد، تعداد رو به رشدی از شرکتهای بزرگ، آژانسها و فریلنسرها دریافتهاند که اجرای بارهای کاری (Workloads) هوش مصنوعی به صورت محلی (Locally) یا روی زیرساخت اختصاصی، سریعتر، ارزانتر و منعطفتر از تکیه صرف به APIهای ابری است.

در موقعیتهای زیر، سرورهای هوش مصنوعی تفاوتی چشمگیر ایجاد میکنند:

استنتاج بلادرنگ (Real-Time Inference)

اگر گرداننده چتباتها، موتورهای توصیهگر (Recommendation Engines)، ابزارهای پشتیبانی خودکار یا سیستمهای بینایی ماشین هستید، «سرعت» حرف اول را میزند.

با استفاده از سرورهای هوش مصنوعی، پاسخها و پیشبینیهای فوری برای کاربران خود دریافت میکنید؛ چرا که دیگر خبری از تأخیرهای ناشی از منابع اشتراکی ابری یا تعدد هاپهای شبکه (Network Hops) نیست.

• مثال: یک آژانس وب که ابزار چت یا جستجوی هوشمند ارائه میدهد، میتواند با اجرای فرآیند استنتاج (Inference) روی سرور AI اختصاصی خود، تأخیر را پایین نگه داشته و هزینهها را کاملاً قابل پیشبینی کند.

آموزش مدل هوش مصنوعی (AI Model Training)

بسیاری از کسبوکارها دیگر تنها به APIهای هوش مصنوعی شخص ثالث (Third-party) متکی نیستند. آنها در حال ارتقای مدلهای خودشان و اعمال تنظیمات خاص برای بهبود دقت هستند.

برای دستیابی به این هدف، شما به یک سرور هوش مصنوعی نیاز دارید که به پردازش شتابیافته، استخرهای حافظه بزرگ و ورودی/خروجی (I/O) سریع مجهز باشد.

• مثال: یک تیم محصول میتواند با متناسبسازی (Fine-tuning) یک مدل زبانی بزرگ (LLM) متنباز روی زیرساخت داخلی، از قدرت پردازشی مستقیم و کنترلشده برای بهبود دستیار هوشمند خود بهرهمند شود.

پیادهسازیهای هوش مصنوعی در محل (On-Site AI Deployments)

برخی از بارهای کاری نمیتوانند ریسک تأخیر ابر (Cloud Latency) را بپذیرند یا دادههای حساس را در معرض اینترنت قرار دهند. اینجاست که سرورهای هوش مصنوعی لبه (Edge AI) کارآمد هستند:

- • تصمیمگیریهای آنی و لحظهای (مانند رباتیک و اتوماسیون صنعتی).

- • کنترلهای سختگیرانه حریم خصوصی دادهها.

- • پردازش اینترنت اشیا (IoT) یا تحلیل ویدیو در محل.

• مثال: یک کارخانه تولیدی که سیستمهای بینایی ماشین را برای تشخیص نقص قطعات اجرا میکند، ممکن است یک سرور هوش مصنوعی را مستقیماً در محل کارخانه مستقر کند.

رشد بازار

با ظهور هوش مصنوعی مولد (Generative AI)، تقاضای جهانی شتاب گرفته است. ارزش بازار سرورهای هوش مصنوعی در سال ۲۰۲۴ تقریباً ۱۲۴.۸۱ میلیارد دلار بوده است. علاوه بر این، گزارشهای کارشناسی تخمین میزنند که بازار سرورهای هوش مصنوعی تا سال ۲۰۳۰ با نرخ رشد مرکب سالانه (CAGR) حدود ۳۸.۷ درصد، به رقم ۸۵۴ میلیارد دلار خواهد رسید (منبع: Grand View Research).

اگر در حال ساخت قابلیتهای هوش مصنوعی، مدیریت حجم عظیمی از دادهها یا ارائه خدمات مبتنی بر AI هستید، سازمان شما برای ماندن در کورس رقابت باید با سرورهای هوش مصنوعی آشنا باشد.

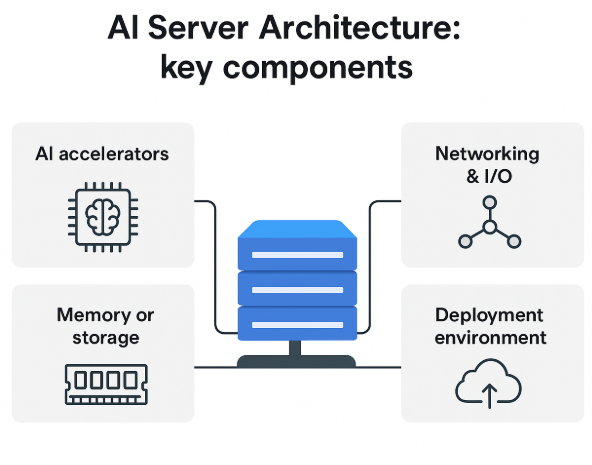

معماری و قطعات حیاتی

سرورهای هوش مصنوعی از بیرون شاید فرق چندانی با سرورهای معمولی نداشته باشند، اما وقتی درب کیس آنها را باز کنید، خواهید دید که معماری داخلیشان کاملاً متفاوت است. این طراحی ویژه، امکان انتقال برقآسای حجم عظیمی از داده، اجرای موازی و پرقدرت کارها و تسهیل پردازشهای سنگین آموزش (Training) و استنتاج (Inference) را فراهم میکند.

برای درک بهتر عملکرد یک سرور AI، بیایید نگاهی کلی به قطعات آن بیندازیم و خیلی وارد جزئیات مهندسی نشویم.

مؤلفههای سختافزاری

بارهای کاری (Workloads) هوش مصنوعی با قطعات سختافزاری خاصی کار میکنند. هنگام خرید یا ارزیابی یک سرور، تمرکزتان باید روی این اجزای کلیدی باشد:

CPU و شتابدهندههای هوش مصنوعی (AI Accelerators)

مغز متفکر سرور، همان CPU است، اما برخلاف سرورهای معمولی، در اینجا تمام بار اصلی را به دوش نمیکشد. وظایف هوش مصنوعی شدیداً وابسته به شتابدهندههایی مثل موارد زیر هستند:

- • GPU: بهترین گزینه برای پردازش موازی و شبکههای عصبی.

- • TPU: بهینهسازی شده برای بارهای کاری یادگیری عمیق (Deep-Learning).

- • FPGA: برای ساخت روالهای هوش مصنوعی سفارشی قابل پیکربندی است.

شتابدهندهها خود فرآیند آموزش و استنتاج را مدیریت میکنند و CPU صرفاً کارهای مدیریتی و هماهنگی عملیات سیستمی را انجام میدهد.

حافظه و فضای ذخیرهسازی

سیستمهای هوش مصنوعی باید بتوانند در کوتاهترین زمان به حجم عظیمی از داده دسترسی پیدا کنند. به همین دلیل در سرورهای AI از موارد زیر استفاده میشود:

- • حافظه HBM (حافظه با پهنای باند بالا) برای رفع گلوگاههای انتقال داده در طول فرآیند آموزش مدل، ضروری است.

- • حافظههای NVMe یا SSD پرسرعت برای تسریع چرخههای خواندن و نوشتن (Read/Write).

تمامی این عناصر در کنار هم قرار میگیرند تا جریان داده، بهویژه هنگام کار با مدلهای بزرگ، به روانی انجام شود.

شبکه و ورودی/خروجی (I/O)

از آنجایی که بارهای کاری AI دائماً در حال جابهجایی داده و توزیع در سیستمهای مختلف هستند، این سرورها متکی به موارد زیر هستند:

- • اتصالات پرسرعت اترنت یا فیبر نوری.

- • کابلهای سفارشی (مانند NVLink) برای ارتباط سریع و پایدار بین GPUها.

- • مسیرهای I/O (ورودی/خروجی) با پهنای باند بالا تا سرعت کار کاهش پیدا نکند.

یک شبکه کارآمد تضمین میکند که مدل با نهایت سرعت اجرا شود و پاسخ استنتاجها در سریعترین زمان ممکن به دست کاربر برسد.

محیطهای استقرار و مدلهای نصب

قرار نیست همه سرورهای هوش مصنوعی در دیتاسنترهای غولآسا نصب شوند. محل و روش نصب سرور مستقیماً بر عملکرد، هزینه و توجیه اقتصادی پروژه شما تأثیر میگذارد.

سرورهای فیزیکی، ابری، ترکیبی و لبه

سرور فیزیکی یا در محل (On-premises)

- • اگر سرورهای AI را در محیط اختصاصی خودتان نصب کنید، کنترل ۱۰۰ درصدی بر داده، امنیت و نحوه شخصیسازی سرور خواهید داشت.

- • مناسب برای سازمانهایی که بدون هیچگونه تأخیری نیاز به پردازشهای محلی دارند.

سرورهای AI مبتنی بر فضای ابری (Cloud-Based)

- • ارائهدهندگان ابری توان پردازشی هوش مصنوعی را به شکل منعطف و مقیاسپذیر در اختیار شما میگذارند.

- • گزینهای عالی برای تیمهایی است که در حال آزمایش هستند یا میخواهند بارهای کاری خود را به صورت لحظهای و پویا مدیریت کنند.

استقرار ترکیبی (Hybrid)

- • برخی شرکتها، سیستمهای ابری و محلی را با هم ترکیب میکنند؛ مثلاً از فضای ابری برای بارهای محاسباتی موقتی (Burst Compute) و از ماشینهای محلی برای استنتاجهای روتین استفاده میکنند.

- • این تنظیمات باعث میشود تعادلی عالی بین هزینه، عملکرد و میزان کنترل برقرار شود.

سرورهای هوش مصنوعی لبه (Edge AI Servers)

- • استقرار در لبه (نزدیک منبع داده) برای کاربردهای بیدرنگ (Real-time) و حساس به زمان، ایدهآل است.

- • کاربردها: رباتیک، اینترنت اشیای صنعتی (IIoT) و تحلیل ویدیو در همان محل.

الزامات زیرساختی

سرورهای هوش مصنوعی به چیزی بیشتر از یک جای خالی در رک نیاز دارند. قبل از نصب و پیادهسازی، این نکات را جدی بگیرید:

- • شتابدهندههای هوش مصنوعی به مراتب مصرف برق بالاتری دارند.

- • نیازهای خنکسازی (کنترل دقیق دما حیاتی است).

- • فضای فیزیکی و ابعاد رک (Rack) سرور.

- • لزوم ارتقای شبکه برای پشتیبانی از جریان بالای داده در دیتاسنتر.

UltaAI – دستیار هوشمند اولتاهاست، همیشه در کنار شما

UltaAI همان دستیار هوشمند و اختصاصی پشتیبانی اولتاهاست است. این ابزار قدرتمند با تکیه بر هوش مصنوعی طراحی شده تا در مدیریت سرویسهای میزبانی (Hosting)، ثبت دامنهها، پیگیری صورتحسابها و حل سریع مشکلات فنی، فوراً و با هوشمندی کامل شما را راهنمایی کند.

تصمیم بگیرید: آیا خرید سرور هوش مصنوعی برای شما منطقی است؟

سرورهای هوش مصنوعی غولهای پردازشی هستند، اما واقعیت این است که همه کسبوکارها به این قدرت عظیم نیاز ندارند. قبل از هر اقدامی، باید هزینههای خرید سختافزار و تغییر زیرساخت را در مقابل حجم کاری، اهداف بلندمدت و البته بودجه موجود، به خوبی سبک و سنگین کنید.

در ادامه، کاربردیترین نقشه راه برای رسیدن به یک تصمیم درست را آوردهایم:

با سؤالات کلیدی شروع کنید

ابتدا، به برنامهریزیهای فعلی و آتی خود برای استفاده از هوش مصنوعی نگاه کنید.

بار کاری اصلی شما چیست؟ (آموزش یا استنتاج)

- اگر کارتان آموزش مدلهای سفارشی و بزرگ است، باید سراغ شتابدهندهها و حافظه با پهنای باند بالا بروید.

- اما اگر هدف فقط استنتاج (Inference) است، نمونههای کوچکتر ابری یا سرورهای محلی میتوانند کارآمد و اقتصادی باشند.

حجم کاری شما چقدر است؟ (کم یا زیاد؟)

- برای وظایف گهگاهی و کمتعداد، میتوانید از محیط ابری استفاده کنید.

- اگر بار کاری شما مکرر و سنگین است، در بلندمدت خرید سختافزار اختصاصی بسیار بهصرفهتر خواهد بود.

تأخیر (Latency) چقدر برایتان تعیینکننده است؟

- ابزارهای بیدرنگ (Real-time) مانند رباتیک و بینایی ماشین، تحمل تأخیر ندارند و احتمالاً به سرورهای در محل (On-prem) نیاز دارند.

- برای کارهایی که کمی تأخیر برایشان قابل اغماض است (مثل تحلیلهای غیرفوری)، منابع ابری انتخابهای اقتصادیتری هستند.

آیا به کنترل صددرصدی روی دادهها نیاز دارید؟

- اگر نگرانیهای حریم خصوصی (Privacy) در صنعت شما بالاست، بسیاری از شرکتها ترجیح میدهند برای حفظ کنترل کامل بر دادههای حساس، از سرورهای هوش مصنوعی محلی یا خصوصی استفاده کنند.

آمادگی زیرساختی و بررسی هزینهها

سرورهای هوش مصنوعی در بحث زیرساخت، به شدت پرتقاضا هستند. پیش از پیادهسازی، حتماً موارد زیر را بررسی کنید:

- آیا دیتاسنتر شما ظرفیت برق کافی برای تغذیه سرورهای GPU-محور را دارد؟

- وضعیت سیستمهای خنککننده و HVAC چگونه است؟ (کنترل دقیق دما حیاتی است).

- آیا فضای فیزیکی رک کافی برای جا دادن سرورهای جدید را دارید؟

- آیا برای پوشش هزینههای نگهداری و تعمیر سختافزاری آمادهاید؟

- و نکته آخر، آیا تیم فنی شما توانایی مدیریت و راهاندازی این سیستمها را دارد؟

مقایسه گزینههای پیشروی شما

| گزینه | بهترین کاربرد | مزایا | معایب |

| میزبانی اشتراکی استاندارد (Standard Shared Hosting) | وبسایتها و وبلاگها | مقرونبهصرفه و مدیریت آسان | نامناسب برای بارهای کاری هوش مصنوعی |

| میزبانی VPS | ابزارهای کوچک | کنترل بیشتر و تنظیمات سفارشی | محدودیت برای آموزش (Training) |

| سرور اختصاصی هوش مصنوعی (Dedicated AI Server) | آموزش/استنتاج هوش مصنوعی | کنترل کامل و عملکرد قابل پیشبینی | برق، خنکسازی، نگهداری |

| هوش مصنوعی ابری (Cloud AI) | بارهای کاری انعطافپذیر یا کوتاهمدت | ارتجاعی (Elastic)، بدون نیاز به سرمایهگذاری سختافزاری | هزینه بالاتر |

اگر حجم کاری شما نوسان زیادی دارد، گزینههای ابری (مانند نمونههای GPU، سرویسهای مدیریتشده یادگیری ماشین) گزینههای مطمئنتری هستند. با این حال، اگر بهطور مداوم بارهای کاری سنگین را اجرا میکنید، داشتن یک سرور هوش مصنوعی به سرمایهگذاری اقتصادی عاقلانهتری در طول زمان تبدیل میشود.

چکلیست تصمیمگیری

- اگر چند مورد از موارد زیر شامل حال شما میشود، ممکن است به یک سرور هوش مصنوعی نیاز داشته باشید:

- شما بهطور منظم مدلهای هوش مصنوعی را آموزش (Train) یا تنظیم دقیق (Fine-tune) میکنید.

- شما سرویسهای هوش مصنوعی بلادرنگ (Real-time) را نگهداری میکنید که در آنها حتی اندکی تأخیر میتواند نتایج را تغییر دهد.

- هزینههای استنتاج ابری (Cloud Inference) غیرقابل پیشبینی هستند یا به سرعت در حال افزایشاند.

- شما دادههای حساس را مدیریت میکنید و ترجیح میدهید کنترل سیستمهای محلی خود را حفظ کنید.

- شما یک سیستم برق و خنککننده مناسب دارید (یا میتوانید بهراحتی بسازید).

- شما تمایل دارید بهرهوری اقتصادی پایدار را در طول زمان برای بارهای کاری حفظ کنید.

- تیم شما مهارتهای لازم برای مدیریت سختافزار را دارد، یا آنها استقلال کامل بر روی سیستم را ترجیح میدهند.

موازنهها و ریسکها (Trade-Offs & Risks)

اگرچه قدرت سرورهای هوش مصنوعی تحسینبرانگیز است، اما معایب آن نیز قابل توجه هستند و باید توسط هر کسبوکار، آژانس یا فریلنسری در نظر گرفته شوند. این موازنههای مهم را به خاطر بسپارید:

- سختافزار بهینهسازی شده برای هوش مصنوعی (GPUها، TPUها، پهنای باند بالا و غیره) گران هستند و با هزینههای عملیاتی مداوم مانند خنکسازی، برق و نگهداری، ممکن است هزینه آن از یک سرور معمولی فراتر رود.

- اگر وظایف هوش مصنوعی شما سبک، کمتکرار یا فصلی هستند، ممکن است در نهایت هزینه اضافه برای سختافزار بپردازید؛ در حالی که برای وظایف بیکار (Idling tasks)، استفاده از سرویسهای ابری میتواند بهرهوری منابع بهتری داشته باشد.

- به دلیل پیچیدگی بیشتر در زیرساخت، به کارکنان متخصصتر و همچنین پیکربندی و بهینهسازی بیشتر سرور نیاز است.

- سختافزار هوش مصنوعی فضای قابل توجهی اشغال میکند و به خنکسازی قوی نیاز دارد، بهویژه برای کاربردهای بنیادی هوش مصنوعی. پایداری (Sustainability)، خروجی گرما و ردپای کربن عملیاتی برای شرکتهایی که به دنبال کاهش اثرات زیستمحیطی خود هستند، بهطور فزایندهای آشکار میشود.

اگر بار کاری، منابع و طرح پیادهسازی بلندمدت منطقی باشد، سرور هوش مصنوعی میتواند خروجی عملیاتی را در تمام سطوح بهطور چشمگیری بهبود بخشد. اگر نه، شاید یک راهکار تجاری ترکیبی (Hybrid) و انعطافپذیر، گزینه اولیه مناسبتری باشد.

روندهای آینده و چشمانداز پیشرو

تأثیر هوش مصنوعی بر زیرساختهای حیاتی بسیار گسترده است و از فریلنسرها گرفته تا بزرگترین شرکتها را شامل میشود. در سالهای پیشرو، دسترسی و نحوه استقرار منابع محاسباتی و قابلیتهای هوش مصنوعی دچار تحول اساسی خواهد شد.

در اینجا به چند مورد از تغییرات بنیادی که در افق نزدیک رخ خواهند داد، اشاره میکنیم:

| روندها | پیامد تجاری |

| رشد سرورهای هوش مصنوعی لبه (Edge AI) | عملکرد محاسباتی هوش مصنوعی همراه با بهرهوری در مصرف انرژی عملیاتی، امکان دسترسی به قابلیتهای پیشرفته هوش مصنوعی را برای تیمهای کوچکتر فراهم میکند. |

| ابر هیبریدی (Hybrid Cloud) و لبه | در مدل هیبریدی، آموزش مدل (Train) در فضای ابری (Cloud) انجام میشود و استنتاج (Inference) در لبه شبکه یا در یک موقعیت خصوصی (Private) صورت میگیرد. |

| نوآوریهای نوظهور | کاهش تولید گرما و پیشرفتهای مهندسی در ساختمانها یا دیتاسنترها، امکان انجام کارها را به شکلی پایدارتر فراهم میکند. اجرای بارهای کاری (Workloads) هوش مصنوعی همزمان از نظر عملیاتی کمهزینهتر و پایدارتر خواهد شد. |

| پیشرفتهای حوزه پایداری (Sustainability) | کاهش تولید گرما و پیشرفتهای مهندسی در ساختمانها یا دیتاسنترها، امکان انجام کارها را به شکلی پایدارتر فراهم میکند. اجرای بارهای کاری هوش مصنوعی، همزمان از نظر عملیاتی کمهزینهتر و پایدارتر خواهد شد. |

| میزبانی و خدمات مدیریتشده «آماده برای هوش مصنوعی» (AI-ready) | این میزبانها سرویس «محاسبات مدیریتشده هوش مصنوعی» (Managed AI Compute) را ارائه میدهند که ورود به بازار هوش مصنوعی را بهمراتب عملیتر و مقرونبهصرفهتر میسازد. |

سرورهای هوش مصنوعی به سمت معماریهای سریعتر، خنکتر و توزیعشدهتر حرکت خواهند کرد و این امر سازمانها را قادر میسازد تا بدون تحمل هزینههای کلان، هوش مصنوعی را پیادهسازی کنند.

چک لیست ارزیابی سریع – آیا سرور هوش مصنوعی برایتان منطقی است؟

کافی است به این چکلیست ساده و سرراست پاسخ دهید تا متوجه شوید سرور AI تا چه حد برای شرکت شما توجیه اقتصادی و فنی دارد.

تناسب با مورد استفاده (Use-case fit)

- آیا حجم کار شما به گونهای است که نیاز دارید مدلهای هوش مصنوعی را در داخل سازمان (In-house) آموزش دهید (Train) یا آنها را تنظیم دقیق (Fine-tune) کنید؟

- آیا قصد دارید عملیات استنتاج (Inference) را در مقیاس بسیار بالا (مثلاً برای سیستمهای چت، بینایی ماشین یا توصیهگرها) انجام دهید؟

- آیا به دلیل الزامات حریم خصوصی یا قوانین انطباقپذیری (Compliance)، به پردازش محلی/درونسازمانی (On-premise) یا با تأخیر بسیار پایین (Low-latency) نیاز دارید؟

تخمین مقیاس کار (Estimated Scale)

- حجم مورد انتظار درخواستها در هر ثانیه یا دقیقه چقدر است؟ (یعنی نرخ درخواستها)

- پیچیدگی و اندازه مدل شما چقدر است؟ (مثلاً مدلهای سنگین بینایی ماشین یا مدلهای زبان بزرگ – LLMها)

- سطح تأخیر مورد نظر شما چقدر است؟ آیا باید بلادرنگ (Real-time) باشد، تقریباً بلادرنگ (Near-real-time) یا پردازش دستهای (Batch) کفایت میکند؟

آمادگی زیرساخت فعلی (Infrastructure Readiness)

- چه میزان توان برق، سیستم خنککننده، و فضای رک در دیتاسنتر یا محیط شما در دسترس است؟

- آیا پرسنل متخصص برای راهاندازی، نگهداری روزمره و نظارت (Monitoring) بر این سرورها وجود دارند؟

- آیا محیط فیزیکی و نرمافزاری شما قابلیت میزبانی از شتابدهندهها (Accelerators) / GPUها را دارد؟

تناسب با هزینه و بودجه (Cost & Budget Fit)

- هزینههای عملیاتی (OPEX) سختافزاری شما چقدر خواهد بود؟ (شامل برق، خنکسازی و تعمیرات دورهای)

- هزینههای نرمافزاری چطور؟ (ابزارهای نظارتی، لایسنسها، پشتیبانی فنی)

- با توجه به حجم بالای استفاده، در مقایسه با هزینههای سرویسهای ابری (Cloud)، آیا مالکیت این سختافزار از نظر اقتصادی بهصرفه است؟

تضمین آیندهنگری (Future-Proofing)

- آیا این محیط امکان مقیاسگذاری آسان (Easy Scaling) را فراهم میکند؟ (مثلاً اضافه کردن آسانتر GPU/شتابدهندههای بیشتر یا لینکهای سریعتر)

- آیا در آینده، امکان حرکت به سمت معماری ترکیبی (Hybrid) یا استفاده از محاسبات لبه شبکه (Edge Computing) وجود دارد؟

- آیا ترجیح میدهید یک سیستم ماژولار (قابل تنظیم قطعهبهقطعه) داشته باشید یا سیستمی که بهراحتی قابل ارتقا باشد؟

اگر پاسخهای شما به این لیست مثبت است، میتوانید مطمئن باشید که سرور هوش مصنوعی با حجم کاری، بودجه و برنامههای بلندمدت شما همخوانی دارد.

UltaHost چطور به شما کمک میکند؟

اولتاهاست (UltaHost) یک گزینه عالی برای کسانی است که به دنبال کاوش یا استقرار سختافزار AI با هزینه کمتر هستند. این پلتفرم تجهیزات کلیدی را برای شروعکنندگان و آزمایشکنندگانی که میخواهند زیرساخت AI را بدون سرمایهگذاری کامل روی یک سرور جدید امتحان کنند، در خود جای داده است.

در واقع، اولتاهاست یک راه میانی عالی برای شرکتهایی فراهم میکند که میخواهند تجهیزات AI را مستقر کنند؛ بهخصوص آنهایی که ترجیح میدهند بدون هزینههای گزاف و پیچیدگیهای مالکیت یک سرور اختصاصی قدرتمند، از سختافزار بهره ببرند. پلتفرمهای میزبانی VPS، سرور اختصاصی و میزبانی ابری (Cloud Hosting) اولتاهاست تمام قطعات مورد نیاز تیم شما را برای شروع بارهای کاری AI فراهم میکنند؛ از خطوط لوله داده بزرگ و API Gateways گرفته تا میزبانی مدلها برای وظایف استنتاج کوچکتر یا راهاندازی سرورهای ترکیبی که به شتابدهندههای محاسبات ابری شما متصل میشوند.

اولتاهاست با ارائهی انعطافپذیری، قیمتگذاری شفاف، حافظههای NVMe SSD، ۹۹.۹٪ آپتایم و مهمتر از همه، پشتیبانی ۲۴/۷ انسانی، تمامی نیازهای شما را پوشش میدهد.

سوالات متداول

آیا میتوانم از سرور معمولی برای بارهای کاری هوش مصنوعی استفاده کنم؟

برای کارهای سبک و کوچک، بله، اما نباید انتظار عملکرد بالایی داشته باشید. سرورهای استاندارد از بسیاری از بهینهسازیها (مثل شتابدهندهها، حافظه و I/O سریع) که بارهای کاری AI به آنها نیاز دارند، بیبهرهاند.

کدام سازمانها باید جدی به فکر خرید سرور AI باشند؟

سازمانهایی که به طور مستمر مدلها را آموزش میدهند، استنتاج در مقیاس بسیار بالا (کاربران زیاد یا نیاز به تأخیر صفر) را مدیریت میکنند یا به دلیل الزامات خاص، AI را در محل (لبه یا Edge) پیادهسازی میکنند. معمولاً سایتها و هاستینگهای کوچک به سرور اختصاصی AI نیازی ندارند.

تفاوت اصلی بین محاسبات ابری AI و سرور اختصاصی چیست؟

AI ابری انعطافپذیری (Pay-as-you-go)، حذف کامل بار زیرساختی و دسترسی سریع را به شما میدهد. در مقابل، مالکیت سرور AI کنترل بیشتر و برای بارهای کاری سنگین، صرفهجویی بالقوه در بلندمدت را فراهم میکند، اما نیازمند سرمایهگذاری اولیه، زیرساخت فیزیکی و هزینههای عملیاتی اضافی است.

اهمیت هزینه برق و زیرساخت سرورهای AI چقدر است؟

پاسخ: بسیار قابل توجه است. سرورهای AI برق بسیار بیشتری مصرف میکنند و در مقایسه با سرورهای معمولی، به خنکسازی و فضای بیشتری نیاز دارند. با توجه به رشد مراکز داده بهینهشده برای AI، مصرف انرژی و خنکسازی امروزه از عوامل اصلی تصمیمگیری هستند.

با وجود پیشرفت سریع سختافزاری، آیا سرورهای AI زود منسوخ نمیشوند؟

سختافزار (شتابدهندهها، فرم فاکتورها، استقرارهای لبه) به سرعت در حال تغییر است، بنابراین برنامهریزی برای مسیر ارتقاء حیاتی است. اما نقش اصلی سرورهای AI (پشتیبانی از آموزش/استنتاج) ثابت میماند. ریسک اصلی این است که درگیر سختافزارهای قدیمی و از رده خارج شوید.