Wraz z upowszechnianiem się narzędzi biznesowych opartych na sztucznej inteligencji pojawia się nowe pytanie: czy wystarczy standardowy serwer, czy potrzebny jest dedykowany serwer AI?

Niezależnie od tego, czy tworzysz aplikacje, wykonujesz analitykę danych, czy dopiero eksplorujesz możliwości AI w swojej firmie, ten przewodnik wyjaśnia, czym jest serwer AI, dlaczego jest ważny i jak ocenić, czy warto w niego zainwestować.

Wprowadzenie

Wykorzystanie sztucznej inteligencji w biznesie widać po wprowadzaniu chatbotów, automatyzacji, prognozowania, rozpoznawania obrazów oraz analizy strumieni danych. Jednak obciążeń generowanych przez te aplikacje nie są w stanie udźwignąć tradycyjne, podstawowe współdzielone serwery używane do hostingu stron www lub prostych aplikacji.

W prostych słowach, serwer AI to wysokowydajny, dedykowany system komputerowy używany do realizacji wybranych, zasobożernych zadań związanych ze szkoleniem (treningiem) lub wykonywaniem (inference) zadań AI. Zadania te wymagają wysokowydajnego trenowania lub wykonywania modeli AI, a tym samym dużej pojemności pamięci i wysokiego progu jej wydajności, a także specjalistycznego sprzętu.

Upowszechnienie narzędzi AI wyrównało szanse w wielu branżach. Niezależnie od tego, czy chodzi o duże korporacje, małych przedsiębiorców, specjalistów IT, freelancerów czy agencje kreatywne – korzystanie z narzędzi AI w celu zwiększenia produktywności i automatyzacji zadań stało się standardową praktyką.

Przyjrzyjmy się więc, czym jest serwer AI, czym różni się od zwykłego serwera i gdzie zazwyczaj się go lokuje.

Kluczowe wnioski

- Serwery AI są projektowane do wymagających zadań treningowych i inferencyjnych, których standardowe serwery nie są w stanie obsłużyć.

- Wykorzystują akceleratory, takie jak GPU i TPU, w połączeniu z pamięcią o wysokiej przepustowości i szybkim dyskiem NVMe, co zapewnia ponadprzeciętną wydajność.

- Firmy, które uruchamiają systemy AI w czasie rzeczywistym, trenują własne modele lub przetwarzają dane wrażliwe, zyskują znaczącą przewagę w szybkości i kontroli dzięki dedykowanej infrastrukturze AI.

- Wybór między chmurą, rozwiązaniem hybrydowym a infrastrukturą on‑premises zależy od kosztów, wymagań dotyczących opóźnień i częstotliwości uruchamiania ciężkich zadań.

- UltaHost pomaga zespołom wdrażać AI w bardziej przystępny sposób, oferując szybki hosting NVMe, platformy gotowe na GPU oraz niskopoziomowo złożony sposób rozpoczęcia pracy bez konieczności zakupu drogiego sprzętu.

Czym jest serwer AI?

Serwer AI to komputer zaprojektowany w konkretnym celu: do uruchamiania obciążeń związanych ze sztuczną inteligencją. Nie koncentruje się na codziennych zadaniach, takich jak hosting stron internetowych czy przetwarzanie typowych aplikacji. Serwer AI obsługuje trening modeli, inferencję w czasie rzeczywistym i przepływ ogromnych ilości danych, które wymagają znacznie większej mocy obliczeniowej i przetwarzania równoległego niż typowy serwer.

W przeciwieństwie do tradycyjnych serwerów, które w dużym stopniu naśladują komputery biurkowe, opierając się głównie na procesorach CPU, serwery AI zwykle wykorzystują wyspecjalizowane akceleratory, takie jak GPU, TPU czy FPGA, do przetwarzania ogromnych zbiorów danych.

Wykorzystują również pamięć o wysokiej przepustowości, szybsze nośniki danych oraz ulepszoną sieć, aby zapewnić płynny przepływ informacji wymagany przez nowoczesne modele AI.

Taka konstrukcja sprawia, że serwery AI dobrze nadają się do takich zastosowań jak:

- trenowanie dużych modeli uczenia maszynowego,

- chatboty i systemy konwersacyjne AI prowadzące interakcje w czasie rzeczywistym,

- przetwarzanie hurtowych paczek obrazów lub wideo,

- wykorzystywanie systemów AI na brzegu sieci (edge) w celu zapewnienia niskich opóźnień odpowiedzi.

Podsumowując, serwer AI to nie tylko szybszy komputer. To środowisko obliczeniowe zaprojektowane specjalnie do tego celu i dostrojone do wymagań nowoczesnych modeli sztucznej inteligencji.

Serwer AI a standardowy serwer

| Funkcja | Standardowy serwer | Serwer AI |

| Główne zastosowanie | Strony WWW, aplikacje | Trening AI, inferencja, przetwarzanie danych |

| Rdzeń obliczeniowy | Tylko CPU | GPU/TPU/FPGA + CPU |

| Pamięć | Umiarkowana | Bardzo duża |

| Przechowywanie danych | Standardowy dysk SSD | Szybki NVMe + duże zbiory danych |

| Sieć | Standardowa przepustowość | Wysoka przepustowość, niskie opóźnienia |

| Typowe obciążenia | Hosting, aplikacje biznesowe | Chatboty, generatywna AI, wizyjne, trening modeli |

Typowe przypadki użycia serwerów AI

Serwery AI nie są już tylko dla wielkich firm technologicznych. Wraz z coraz szerszym włączaniem rozwiązań AI do popularnych produktów i usług, rosnąca liczba przedsiębiorstw, agencji i freelancerów odkrywa, że uruchamianie obciążeń AI lokalnie lub na dedykowanej infrastrukturze jest szybsze, tańsze i bardziej elastyczne niż poleganie wyłącznie na interfejsach API chmury.

Oto sytuacje, w których serwery AI robią realną różnicę.

Inferencja w czasie rzeczywistym

Jeśli korzystasz z chatbotów, silników rekomendacji, zautomatyzowanych narzędzi wsparcia czy systemów wizyjnych, liczy się szybkość.

Dzięki serwerom AI użytkownicy otrzymują natychmiastowe odpowiedzi i prognozy, bez opóźnień związanych ze współdzielonymi zasobami chmury czy dodatkowymi przeskokami w sieci.

Na przykład agencja webowa, która udostępnia klientom czat lub wyszukiwarkę opartą na AI, może utrzymać niskie opóźnienia i przewidywalne koszty, uruchamiając inferencję na własnym serwerze AI.

Trening modeli AI

Wiele firm nie polega już wyłącznie na zewnętrznych interfejsach API AI. Udoskonalają swoje własne modele i wprowadzają zmiany, aby poprawić ich dokładność.

Aby to osiągnąć, potrzebny jest serwer AI z akcelerowanym przetwarzaniem, dużymi zasobami pamięci oraz szybkim I/O.

Przykładowo zespół produktowy może skorzystać z bezpośrednio kontrolowanej mocy obliczeniowej do wewnętrznych cykli strojenia asystenta, adaptując otwarto‑źródłowy LLM.

Wdrożenia AI na miejscu (on‑site)

Niektóre obciążenia nie mogą polegać na opóźnieniach chmury ani wystawiać wrażliwych danych do internetu. W takich przypadkach przydają się serwery AI działające na brzegu sieci (edge) lub lokalnie.

- Podejmowanie decyzji w ułamku sekundy (np. robotyka, automatyka przemysłowa),

- ścisła kontrola nad prywatnością danych,

- przetwarzanie dla urządzeń IoT lub analityka wideo na miejscu.

Na przykład firma produkcyjna, która wykorzystuje systemy wizyjne do wykrywania defektów, może wdrożyć serwer AI bezpośrednio w zakładzie.

Wzrost rynku

Wraz z rozwojem generatywnej AI globalny popyt gwałtownie rośnie. Wartość rynku serwerów AI wyniosła w 2024 roku około 124,81 mld USD. Co więcej, według raportów ekspertów szacuje się, że do 2030 roku rynek serwerów AI osiągnie wartość 854 mld USD przy CAGR na poziomie około 38,7% (Grand View Research).

Jeśli budujesz funkcje oparte na AI, zarządzasz dużymi ilościami danych lub oferujesz usługi oparte na AI, Twoja organizacja musi znać serwery AI, aby pozostać konkurencyjna.

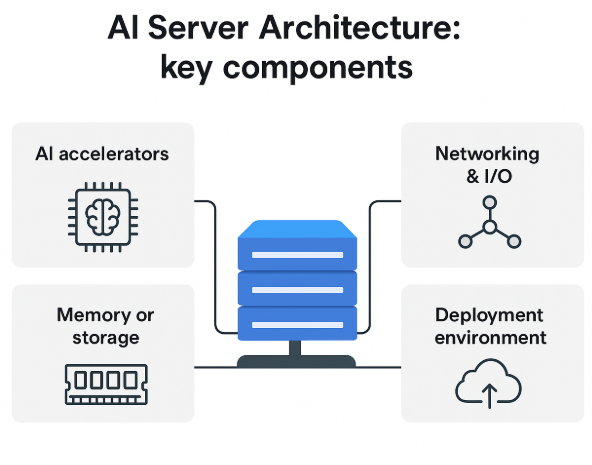

Podstawowa architektura i komponenty

Z zewnątrz serwery AI wyglądają jak zwykłe serwery, ale ich wnętrze zaprojektowane jest inaczej. Architektura umożliwia szybkie przesyłanie dużych wolumenów danych, efektywne wykonywanie zadań równoległych oraz realizację ciężkich zadań treningowych i inferencyjnych.

Oto ogólne wyjaśnienie, jak działa serwer AI, bez wchodzenia zbyt głęboko w szczegóły inżynierskie.

Komponenty sprzętowe

Obciążenia związane ze sztuczną inteligencją korzystają z wielu specjalistycznych komponentów sprzętowych. Wybierając lub oceniając serwer AI, kluczowe jest skupienie się na najważniejszych elementach.

CPU + akceleratory AI

W sercu serwera AI znajduje się procesor CPU, ale nie dźwiga on całego obciążenia. Zadania AI opierają się w dużym stopniu na akceleratorach AI, takich jak:

- GPU – doskonałe do przetwarzania równoległego i sieci neuronowych,

- TPU – dostosowane do obciążeń deep learning,

- FPGA – które można konfigurować tak, aby tworzyć niestandardowe funkcje AI.

Akceleratory zajmują się treningiem i inferencją, podczas gdy CPU zarządza koordynacją zadań i działaniem systemu.

Pamięć i magazyn danych

Systemy AI wymagają szybkiego dostępu do ogromnych ilości danych. Do tego właśnie służą serwery AI.

- HBM, czyli pamięć o wysokiej przepustowości, jest potrzebna, aby eliminować wąskie gardła podczas zadań treningowych,

- pamięć masowa NVMe lub SSD umożliwia szybkie cykle odczytu/zapisu.

Elementy te ułatwiają płynne przesyłanie danych, zwłaszcza podczas uruchamiania większych modeli.

Sieć i I/O

Ponieważ dane są stale przesyłane, obciążenia AI często obejmują systemy rozproszone. Serwery AI opierają się na:

- szybkim Ethernetcie lub łączach światłowodowych,

- specjalnych przewodach (takich jak NVLink) zapewniających niezawodną, szybką komunikację między GPU,

- ścieżkach I/O o dużej przepustowości, które zapobiegają spowolnieniom.

Efektywna sieć gwarantuje, że model działa wystarczająco szybko, a inferencja jest responsywna.

Środowiska wdrożeniowe i form‑factories

Nie każdy serwer AI znajduje się w ogromnym centrum danych. Wydajność, koszt i opłacalność zależą od tego, jak i gdzie go wdrożysz.

Wdrożenia on‑premises, w chmurze, hybrydowe i na brzegu sieci (edge)

On-premises

- Jeśli masz własne środowisko, w którym hostujesz serwery AI, zyskujesz pełną kontrolę nad danymi, bezpieczeństwem i możliwością dostosowania.

- To rozwiązanie jest odpowiednie dla organizacji, które potrzebują lokalnego przetwarzania z minimalnymi opóźnieniami.

Serwery AI w chmurze

- Dostawcy chmury oferują elastyczne, skalowalne zasoby obliczeniowe AI.

- To dobre rozwiązanie dla zespołów, które eksperymentują z AI lub często dostosowują obciążenia.

Wdrożenia hybrydowe

- Część organizacji łączy systemy chmurowe i on‑premises, wykorzystując chmurę do chwilowych skoków zapotrzebowania na moc, a lokalne maszyny do regularnej inferencji.

- Konfiguracje hybrydowe równoważą koszt, wydajność i kontrolę.

Serwery AI na brzegu sieci (edge)

- Wdrożenia brzegowe idealnie sprawdzają się w aplikacjach czasu rzeczywistego, ponieważ znajdują się blisko źródła danych.

- Przykłady zastosowań to roboty, przemysłowe aplikacje IP oraz przetwarzanie wideo w danej lokalizacji.

Wymagania infrastrukturalne

Serwery AI potrzebują czegoś więcej niż tylko miejsca w szafie rackowej. Zanim wdrożysz takie rozwiązanie, weź pod uwagę:

- Akceleratory AI zużywają zdecydowanie więcej energii,

- wymagania chłodzenia (kontrola temperatury jest kluczowa),

- miejsce w szafie rack i przestrzeń fizyczną,

- modernizację sieci pod kątem stałej, wysokiej przepustowości.

UltaAI – inteligentny asystent AI dla klientów UltaHost

UltaAI to inteligentny asystent wsparcia UltaHost, zaprojektowany tak, aby natychmiast pomagać w zarządzaniu hostingiem, domenami, rozliczeniami i kwestiami technicznymi, zapewniając sprytne odpowiedzi generowane przez AI.

Jak zdecydować, czy potrzebujesz serwera AI

Serwer AI może zaoferować ogromną moc, ale nie oznacza to, że zawsze jest konieczny. Koszty sprzętu i zmiany w infrastrukturze należy zawsze zestawić z obciążeniami, celami oraz dostępnym budżetem, zanim podejmie się decyzję.

Poniżej przedstawiono jeden z najbardziej praktycznych sposobów podejścia do tego tematu.

Zacznij od właściwych pytań

Najpierw zastanów się nad obecnym lub planowanym wykorzystaniem AI.

Jakie jest Twoje obecne obciążenie?

- Trening wymaga akceleratorów i pamięci o wysokiej przepustowości. Wymagane są modele niestandardowe i duże.

- W przypadku inferencji wykorzystanie może być bardziej efektywne dzięki mniejszym, lokalnym serwerom lub instancjom w chmurze.

Jakiego obciążenia się spodziewasz?

- Do okazjonalnych zadań trening można realizować w chmurze.

- Jeśli spodziewasz się częstszych lub większych zadań, trening modeli jest zwykle bardziej opłacalny na dedykowanym sprzęcie.

Jak ważna jest latencja (opóźnienie) w danym zadaniu?

- Narzędzia na żądanie lub działające w czasie rzeczywistym mogą wymagać serwerów on‑premises. Dotyczy to m.in. systemów wizyjnych, botów wsparcia, robotyki i podobnych zastosowań.

- W przypadku zadań niekrytycznych pod względem opóźnień zasoby chmurowe mogą być bardziej opłacalne. Warto zauważyć, że są to zadania istotne, ale tolerujące pewne opóźnienia.

Czy dla danego zadania konieczna jest pełna kontrola nad danymi?

- Obawy związane z prywatnością danych sprawiają, że niektóre branże preferują lokalne lub prywatne serwery AI.

Sprawdź koszty i gotowość infrastruktury

Serwery AI zawsze stawiają wyższe wymagania wobec infrastruktury. Upewnij się, że:

- posiadasz wystarczającą moc zasilania, aby obsłużyć serwery mocno obciążone GPU,

- Twoje systemy chłodzenia i HVAC są odpowiednie,

- masz dostępne miejsce w szafach rack i właściwe środowisko do hostingu,

- Twój system jest przygotowany na koszty sprzętu i utrzymania,

- Twój zespół jest w stanie zarządzać konfiguracją.

Porównanie dostępnych opcji

| Opcja | Najlepsza dla | Zalety | Wady |

| Standardowy hosting współdzielony | Strony WWW i blogi | Tani i prosty w zarządzaniu | Nie nadaje się do obciążeń AI |

| VPS | Małe narzędzia | Większa kontrola i możliwość własnych konfiguracji | Ograniczony w zastosowaniach treningowych |

| Dedykowany serwer AI | Trening/inferencja AI | Pełna kontrola i przewidywalna wydajność | Wysokie wymagania dot. zasilania, chłodzenia i utrzymania |

| AI w chmurze | Elastyczne lub krótkotrwałe obciążenia | Elastyczność, brak inwestycji w sprzęt | Wyższe koszty przy dużym obciążeniu |

Jeżeli Twoje obciążenie bardzo się waha, opcje chmurowe (instancje GPU, zarządzane usługi ML) będą bezpieczniejszym wyborem. Jednak gdy stale uruchamiasz ciężkie obciążenia, posiadanie serwera AI staje się z czasem rozwiązaniem bardziej opłacalnym ekonomicznie.

Lista kontrolna decyzji

Możesz potrzebować serwera AI, jeśli zaznaczasz kilka z poniższych punktów:

- Regularnie trenujesz lub dostrajasz (fine‑tuning) modele AI.

- Utrzymujesz usługi AI w czasie rzeczywistym, w których nawet niewielkie opóźnienie może zmienić wyniki.

- Koszty inferencji w chmurze są nieprzewidywalne lub szybko rosną.

- Przetwarzasz wrażliwe dane i wolisz zachować nad nimi pełną kontrolę w lokalnych systemach.

- Masz (lub możesz łatwo zbudować) adekwatną infrastrukturę zasilania i chłodzenia.

- Chcesz zachować długoterminową efektywność ekonomiczną obciążeń.

- Twój zespół ma niezbędne kompetencje do zarządzania sprzętem lub woli pełną autonomię nad systemem.

Kompromisy i ryzyka

Choć możliwości serwerów AI są imponujące, związane z nimi wady również są istotne i powinny być brane pod uwagę przez każdą firmę, agencję czy freelancera. Pamiętaj o następujących kompromisach:

- Sprzęt zoptymalizowany pod AI (GPU, TPU, pamięć o wysokiej przepustowości itd.) jest drogi, a bieżące koszty operacyjne, takie jak chłodzenie, energia elektryczna i utrzymanie, mogą przewyższyć koszty standardowego serwera.

- Jeśli Twoje zadania AI są lekkie, rzadkie lub sezonowe, możesz finalnie przepłacić za sprzęt, podczas gdy utrzymanie usług w chmurze – z zadaniami uruchamianymi tylko w razie potrzeby – byłoby efektywniejszym wykorzystaniem zasobów.

- Z powodu większej złożoności infrastruktury potrzebni są bardziej zaawansowani specjaliści oraz więcej pracy przy konfiguracjach i optymalizacji serwerów.

- Sprzęt AI zajmuje dużo miejsca i wymaga solidnego chłodzenia, szczególnie przy zastosowaniach obejmujących modele fundamentowe. Kwestie zrównoważonego rozwoju, generowania ciepła i śladu węglowego stają się coraz ważniejsze dla firm chcących ograniczać wpływ na środowisko.

Serwer AI, o ile obciążenia, zasoby i długoterminowy plan wdrożenia mają sens, może znacząco poprawić efektywność operacyjną w całej organizacji. Jeśli jednak tak nie jest, elastyczne rozwiązanie hybrydowe może być lepszym wyborem na początek.

Przyszłe trendy i nadchodzące zmiany

Wpływ AI na infrastrukturę podstawową jest ogromny – od freelancerów po największe korporacje. W nadchodzących latach dostępność i sposób wdrażania zasobów obliczeniowych AI oraz ich możliwości ulegną dużej transformacji.

Oto kilka kluczowych zmian, które są już na horyzoncie:

| Trends | Konsekwencje biznesowe |

| Wzrost liczby serwerów edge AI | Wydajność obliczeniowa AI przy większej efektywności energetycznej odblokowuje zaawansowane możliwości AI dla mniejszych zespołów |

| Hybrydowa chmura i edge | Modele będą trenowane w chmurze, a inferencja będzie odbywać się na brzegu sieci lub w lokalizacji prywatnej |

| Nowe innowacje | Ograniczanie emisji ciepła i postęp w inżynierii budynków oraz centrów danych pozwolą pracować w bardziej zrównoważony sposób. Uruchamianie obciążeń AI stanie się jednocześnie mniej kosztowne operacyjnie i bardziej zrównoważone. |

| Postęp w obszarze zrównoważonego rozwoju | Ograniczanie emisji ciepła i postęp w inżynierii budynków oraz centrów danych pozwolą pracować w bardziej zrównoważony sposób. Uruchamianie obciążeń AI stanie się jednocześnie mniej kosztowne operacyjnie i bardziej zrównoważone. |

| „AI‑ready” hosting i usługi zarządzane | Dostawcy oferujący Managed AI Compute sprawiają, że wejście na rynek AI jest znacznie łatwiejsze i bardziej opłacalne. |

Serwery AI będą nadal przyjmować szybsze, chłodniejsze i bardziej rozproszone architektury, umożliwiając organizacjom wdrażanie AI bez ponoszenia ogromnych kosztów.

Szybka lista kontrolna – czy potrzebujesz serwera AI?

Odpowiedz na poniższą, prostą listę kontrolną, aby ocenić, czy serwer AI ma sens w Twojej firmie. Zachowaj jasność, konkret i praktyczne podejście, skupiając się na codziennym podejmowaniu decyzji.

Dopasowanie do przypadku użycia

- Czy w firmie zachodzi potrzeba trenowania lub dostrajania modeli AI na miejscu?

- Czy realizujesz inferencję na dużą skalę (czat, wizja, rekomendacje)?

- Czy potrzebujesz przetwarzania o niskich opóźnieniach lub on‑premises ze względu na wymogi zgodności i prywatności?

Szacowana skala

- Jaki jest oczekiwany wolumen żądań (liczba zapytań na sekundę/minutę)?

- Jaka jest złożoność/rozmiar modelu (np. modele wizyjne, LLM)?

- Jakie są wymagania co do opóźnień: czas rzeczywisty, zbliżony do rzeczywistego czy przetwarzanie wsadowe?

Gotowość infrastruktury

- Jaką moc zasilania, chłodzenie i miejsce w szafach rack masz do dyspozycji?

- Czy masz personel do instalacji, utrzymania i monitoringu?

- Czy Twoje środowisko jest w stanie hostować GPU/akceleratory?

Dopasowanie kosztów i budżetu

- Jakie są koszty sprzętu wraz z OPEX (czyli energią, chłodzeniem i naprawami)?

- Jakie są koszty oprogramowania (narzędzia monitoringu, licencje, wsparcie)?

- Jak to się ma do kosztów chmury przy wysokim wykorzystaniu – czy posiadanie sprzętu jest opłacalne?

Przygotowanie na przyszłość

- Czy środowisko umożliwia łatwe skalowanie (więcej akceleratorów/GPU, szybsze połączenia między nimi)?

- Czy w przyszłości możliwe będzie przejście na model hybrydowy lub edge?

- Czy infrastruktura jest modułowa i łatwo ją zmodernizować?

Tak – ta lista ułatwia ocenę, czy serwer AI dobrze pasuje do Twoich obciążeń, budżetu i długoterminowych planów.

Jak pomaga UltaHost

UltaHost stara się zapewnić atrakcyjną opcję dla tych, którzy chcą eksplorować lub wdrażać sprzęt AI przy niższych kosztach. Ten przewodnik zawiera kluczowe informacje o sprzęcie dla osób rozpoczynających pracę i testujących, którzy chcą wejść w świat infrastruktury AI bez konieczności natychmiastowego zakupu nowego, rozbudowanego serwera.

W praktyce UltaHost zapewnia doskonały kompromis dla firm, które chcą spróbować i wdrożyć sprzęt AI, szczególnie dla tych, które chcą korzystać ze sprzętu bez kosztów i złożoności związanej z posiadaniem bardzo rozbudowanego serwera. Platformy UltaHost hosting VPS, serwery dedykowane i Cloud Hosting oferują zespołom wszystkie elementy potrzebne do rozpoczęcia pracy z obciążeniami AI, takimi jak rozbudowane potoki danych, bramki API, hosting modeli dla mniejszych zadań inferencyjnych czy hybrydowe konfiguracje serwerów połączonych z akceleratorami obliczeniowymi w chmurze.

Rozwiązanie to jest elastyczne, z przejrzystym cennikiem, dyskami NVMe SSD, gwarancją dostępności 99,9% oraz 24/7 wsparciem klienta świadczonym przez ludzi – to wszystko otrzymujesz w UltaHost.

FAQ

Czy mogę używać standardowego serwera do obciążeń AI?

Tak, w przypadku mniejszych lub lekkich zadań, ale wydajność może być ograniczona. Standardowe serwery nie oferują wielu optymalizacji (akceleratory, pamięć, I/O), których wymagają obciążenia AI.

Jakie organizacje powinny rozważyć serwer AI?

Organizacje, które prowadzą ciągły trening modeli, obsługują inferencję na dużą skalę (wielu użytkowników lub bardzo niskie opóźnienia) lub wdrażają AI na brzegu sieci przy specyficznych wymaganiach. Mniejszy hosting stron czy proste witryny zazwyczaj nie potrzebują dedykowanego serwera AI.

Czym różni się obliczeniowa moc AI w chmurze od posiadania własnego serwera AI?

Moc obliczeniowa AI w chmurze oferuje elastyczność (płatność za zużycie), brak obciążeń związanych z infrastrukturą i szybki dostęp. Posiadanie serwera AI zapewnia większą kontrolę, potencjalne oszczędności w długim terminie przy dużych obciążeniach, ale wymaga infrastruktury, inwestycji początkowej oraz nakładów na utrzymanie.

Jak duże są koszty energii i infrastruktury serwera AI?

Dość znaczące. Wdrożenia serwerów AI mogą zużywać znacznie więcej energii i wymagać więcej chłodzenia oraz przestrzeni niż standardowe serwery. Wraz z rozwojem infrastruktury centrów danych zoptymalizowanej pod AI, energia i chłodzenie stają się kluczowymi czynnikami.

Czy serwery AI szybko staną się przestarzałe ze względu na szybki postęp sprzętu?

Sprzęt rozwija się szybko (nowe akceleratory, form‑factories, wdrożenia edge), dlatego planowanie ścieżki modernizacji jest ważne. Jednak podstawowa rola serwerów AI pozostaje niezmienna: wspieranie treningu i inferencji. Ryzyko dotyczy bardziej zablokowania się na przestarzałym sprzęcie niż utraty sensu posiadania serwera AI jako takiego.