По мере того как компании всё активнее внедряют инструменты искусственного интеллекта, всё чаще возникает вполне практичный вопрос: можно ли продолжать работать на обычном сервере или уже пора переходить к специализированному AI-решению?

Если вы создаёте собственные приложения, занимаетесь аналитикой или просто изучаете новые возможности ИИ, то рано или поздно столкнётесь с этой дилеммой. В этом материале мы подробно разберём, что именно скрывается за термином «AI-сервер», зачем он нужен и в каких ситуациях его внедрение действительно оправдано.

Введение

Сегодня искусственный интеллект встречается где угодно — от чат-ботов и автоматизированных процессов до прогнозных моделей и систем компьютерного зрения. Но есть нюанс: обычные серверы, которые хорошо справляются с веб-сайтами или классическими приложениями, просто не рассчитаны на такие нагрузки.

Если упростить формулировку, AI-сервер — это мощная специализированная машина, созданная для тяжёлых задач обучения и инференса. Такие workloads требуют огромных массивов памяти, быстрого ввода-вывода и аппаратных ускорителей.

Расширение ИИ сделало технологии доступнее: ими пользуются и крупные корпорации, и небольшие команды, и студии, и фрилансеры. Автоматизация рутинных процессов, улучшение поддержки клиентов, анализ больших данных — всё это стало повседневностью. Поэтому важно понимать, какие возможности даёт AI-сервер и чем он отличается от обычной инфраструктуры.

Давайте разберёмся, что такое AI-сервер, чем он отличается от обычного сервера и где его обычно размещают.

Ключевые выводы

- AI-серверы создаются специально для обучения моделей и выполнения сложных вычислений, с которыми стандартные серверы просто не справляются.

- Они используют GPU, TPU и другие ускорители, а также память с высокой пропускной способностью и NVMe-хранилище — всё это обеспечивает значительно более высокую производительность.

- Организации, которым важны низкие задержки, контроль над данными и возможность тонкой настройки моделей, получают заметные преимущества от выделенной AI-инфраструктуры.

- Выбор между локальным сервером, облачной инфраструктурой или гибридным подходом зависит от бюджета, частоты выполнения тяжёлых задач и требований к скорости.

- UltaHost упрощает внедрение ИИ: NVMe-хостинг, готовые GPU-платформы и доступный порог входа позволяют работать с ИИ без покупки дорогого оборудования.

Что такое AI-сервер?

Сервер ИИ — это компьютер, созданный для конкретной задачи: выполнения рабочих нагрузок, связанных с искусственным интеллектом. Он не предназначен для повседневных задач вроде хостинга сайтов или обработки обычных приложений. Такой сервер выполняет обучение моделей, работу в режиме реального времени и обработку огромных потоков данных, требующих значительно большей мощности и параллельной обработки, чем типичный сервер.

Традиционные серверы в большинстве своём опираются на CPU и стандартную архитектуру, напоминающую обычный ПК. Но в мире ИИ этого недостаточно — нужна высокая параллельность, скорость передачи данных и способность выдерживать тяжёлые вычисления.

Поэтому AI-серверы оснащаются GPU, TPU или FPGA, расширенной памятью, быстрыми NVMe-накопителями и улучшенными сетевыми возможностями. Такая комбинация позволяет им работать с большими датасетами и сложными моделями без узких мест.

Они идеально подходят для задач вроде:

- Обучение больших моделей машинного обучения.

- Запуска чат-ботов и диалоговых систем с мгновенным откликом

- Обработки потокового видео или изображений

- Edge-сценариев, где важны низкие задержки и автономность.

В целом, сервер ИИ — это не просто более быстрый компьютер. Это вычислительная среда, специально разработанная для этой цели и настроенная с учетом требований современного ИИ.

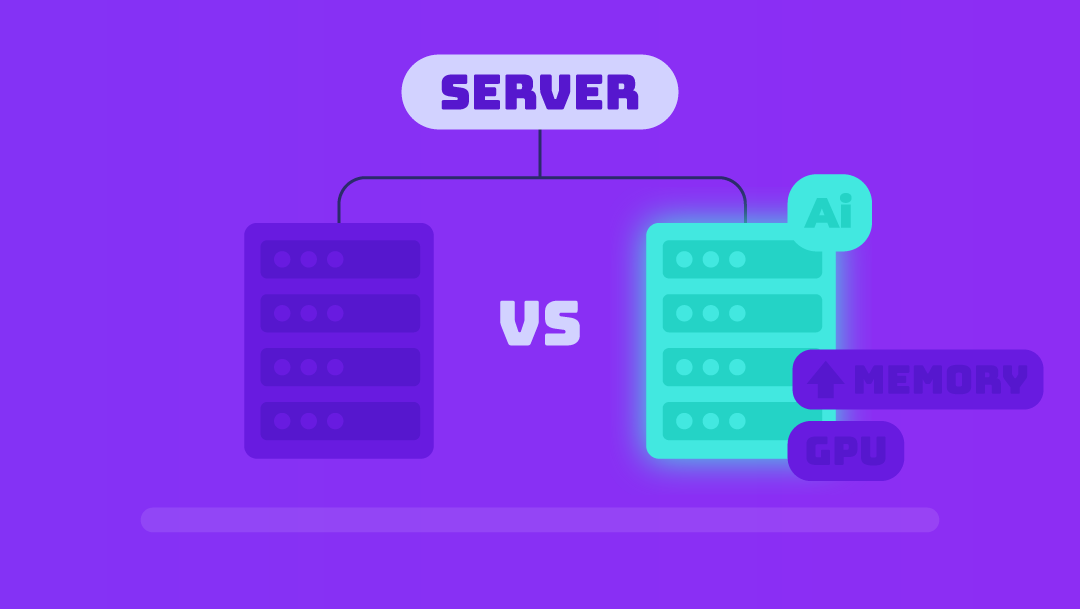

AI-сервер против стандартного сервера

| Функция | Стандартный сервер | AI-сервер |

| Основное использование | Веб-сайты, приложения | Обучение ИИ, вывод, обработка больших объемов данных |

| Основные вычисления | Только CPUs | GPUs/TPUs/FPGAs + CPUs |

| Память | Умеренный | Очень высокий |

| Хранилище | Стандартный SSD | Высокоскоростной NVMe + большие датасеты |

| Сетевое взаимодействие | Обычная пропускная способность | Высокоскоростной, с низкой задержкой |

| Рабочие нагрузки | Хостинг, бизнес-приложения | чат-боты, генеративный ИИ, компьютерное зрение, обучение моделей |

Типичные сценарии использования серверов искусственного интеллекта

Серверы для ИИ уже давно перестали быть чем-то, доступным только крупным корпорациям. По мере того как AI-функции появляются в привычных продуктах и сервисах, всё больше компаний, агентств и фрилансеров понимают: запуск ИИ-нагрузок на собственном или выделенном сервере часто оказывается быстрее, гибче и предсказуемее по стоимости, чем полная зависимость от сторонних облачных API.

Ниже — несколько типичных ситуаций, где отдельный сервер искусственного интеллекта действительно даёт ощутимую пользу.

Инференс в реальном времени

Когда вы работаете с чат-ботами, рекомендательными системами, инструментами автоматизированной поддержки или решениями компьютерного зрения, скорость ответа становится критичным фактором. Пользователь ожидает реакцию «здесь и сейчас», а не через несколько секунд.

Серверы искусственного интеллекта позволяют получать такие быстрые ответы и прогнозы, потому что вычисления выполняются на ваших ресурсах, без дополнительных сетевых «прыжков» и задержек в чужих облаках.

Например, веб-агентство, которое предлагает клиентам чат или внутренний поисковый инструмент на базе ИИ, может разворачивать инференс на собственном AI-сервере. Так оно получает стабильную низкую задержку и понятную, прогнозируемую себестоимость.

Обучение моделей искусственного интеллекта

Всё больше компаний не ограничиваются готовыми API и «чёрными ящиками», а адаптируют модели под свои данные и задачи: дообучают, донастраивают, комбинируют несколько подходов. Это позволяет повысить точность, лучше учитывать специфику отрасли и снизить зависимость от сторонних решений.

Для таких задач уже недостаточно обычной инфраструктуры. Нужен сервер искусственного интеллекта с мощными ускорителями, большими объёмами оперативной и видеопамяти, а также быстрым вводом-выводом данных.

адобится сервер искусственного интеллекта с ускоренными вычислениями, большими пулами памяти и быстрым вводом-выводом.

Пример: продуктовая команда, которая разрабатывает собственного ассистента на базе открытой LLM, может запустить циклы обучения и тонкой настройки на своём AI-сервере. Это даёт полный контроль над процессом и не привязывает команду к лимитам и ценам внешнего провайдера.

Локальные внедрения ИИ

Есть сценарии, где «отправить всё в облако» — не вариант. Либо задержка слишком критична, либо данные слишком чувствительны, чтобы гонять их через внешние сервисы. В таких случаях на первый план выходят edge- и локальные AI-серверы. Они особенно актуальны, когда:

- Решения нужно принимать за доли секунды (робототехника, системы промышленной автоматизации)

- К данным применяются жёсткие требования по конфиденциальности и регуляторике

- Потоки данных с датчиков, камер или IoT-устройств нужно обрабатывать прямо на площадке, не отправляя сырой поток наружу.

Например, производственная компания, которая использует системы машинного зрения для обнаружения дефектов на линии, может установить AI-сервер прямо на объекте. Все вычисления будут выполняться локально, без зависимости от внешнего канала связи.

Рост рынка

По мере того как генеративный ИИ становится массовой технологией, спрос на вычислительные мощности растёт взрывными темпами. В 2024 году рынок серверов для ИИ оценивался примерно в 124,81 млрд долларов США. По прогнозам, к 2030 году он может вырасти до 854 млрд долларов США со среднегодовым темпом роста около 38,7% (по данным Grand View Research).

Если вы разрабатываете AI-функции, управляете большими массивами данных или предлагаете услуги на основе искусственного интеллекта, понимание того, как устроены AI-серверы и как их использовать, постепенно становится не конкурентным преимуществом, а необходимостью.

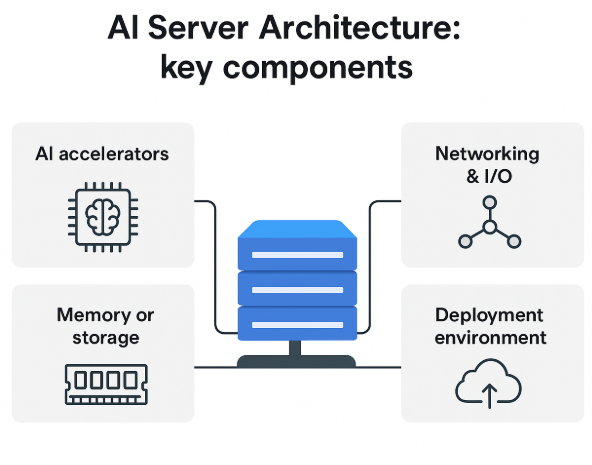

Основная архитектура и компоненты

Снаружи AI-сервер мало чем отличается от обычного. Но «под капотом» он спроектирован по-другому: всё заточено под быструю передачу больших объёмов данных, параллельное выполнение множества операций и тяжёлые задачи обучения и инференса.

Ниже — базовое объяснение того, как устроен сервер искусственного интеллекта, без погружения в слишком низкоуровневые детали.

Аппаратные компоненты

Нагрузки ИИ опираются на набор специализированных компонентов, и именно от них в первую очередь зависит производительность. При выборе AI-сервера имеет смысл смотреть не только на «общую мощность», но и на связку ключевых элементов.

Процессоры + ускорители искусственного интеллекта

В основе любого сервера стоит CPU, но в AI-сценариях он играет скорее роль «координатора» — распределяет задачи, управляет потоками, отвечает за общую работу системы. Основной объём тяжёлых вычислений берут на себя ускорители:

- GPU — видеокарты, оптимизированные под массовую параллельную обработку и вычисления в нейронных сетях.

- TPU — специализированные чипы для глубокого обучения и матричных операций.

- FPGA — программируемые логические матрицы, которые можно гибко настраивать под конкретные алгоритмы и кастомные сценарии.

Именно эти ускорители выполняют обучение и инференс, в то время как CPU управляет их работой и общим состоянием системы.

Память/хранилище

AI-системы постоянно «перелопачивают» огромные объёмы данных, поэтому скорость доступа к ним здесь критична.

- HBM (high-bandwidth memory) с высокой пропускной способностью помогает снять bottleneck при обучении крупных моделей.

- NVMe- или быстрые SSD-накопители обеспечивают высокую скорость чтения и записи, что особенно важно при работе с большими датасетами.

Вместе эти компоненты делают поток данных более плавным и предсказуемым, минимизируя простои из-за медленного диска или узкого канала.

Сетевые подключения и ввод-вывод

AI-задачи редко живут в полном отрыве от остальной инфраструктуры: данные постоянно поступают, обрабатываются и передаются дальше. Часто системы распределены по нескольким серверам или даже по разным площадкам.

- Высокоскоростные Ethernet- или оптоволоконные подключения.

- Специализированные каналы связи между ускорителями (например, NVLink для GPU).

- Широкие каналы ввода-вывода, чтобы не упираться в ограничение по пропускной способности.

От качества сетевой части напрямую зависят скорость ответа моделей и общая отзывчивость системы при инференсе.

Среды внедрения и форм-факторы

AI-серверы можно встретить не только в гигантских дата-центрах. Формат развертывания заметно влияет на стоимость, скорость и удобство эксплуатации. В общих чертах можно выделить несколько подходов.

Сравнение типов развертывания: локальное, облачное, гибридное и периферийное

Локальная инфраструктура

- Серверы размещаются в вашей собственной среде: офисный серверный зал, частный дата-центр и т.п. Вы полностью контролируете данные, безопасность, настройки и политику доступа.

- Такой формат подходит, если важна минимальная задержка и строгий контроль над тем, где и как обрабатываются данные.

Облачные AI-серверы

- Облачные провайдеры предоставляют готовые GPU-инстансы и специализированные AI-платформы. Это удобно, если вы тестируете разные сценарии, часто меняете конфигурации или вам нужно быстро масштабироваться «по требованию».

- Нет необходимости покупать железо и сразу вкладываться в инфраструктуру, но при больших постоянных нагрузках стоимость может быстро расти.

ГИБРИДНЫЕ РАЗВЕРТЫВАНИЯ

- Часть задач выполняется в облаке, часть — на локальных серверах. Облако можно использовать для пиковых или экспериментальных нагрузок, а локальные машины — для регулярного, предсказуемого инференса.

- Такой подход помогает искать баланс между стоимостью, производительностью и степенью контроля.

СЕРВЕРЫ EDGE AI

- Располагаются как можно ближе к источнику данных: на заводе, в магазине, в офисе, на объекте. Подходят для сценариев, где важны реакции в реальном времени и нет возможности или желания отправлять все данные в облако.

- Это частый выбор для промышленных IoT-систем, робототехники и локальной видеоаналитики.

Требования к инфраструктуре

Развернуть AI-сервер — это не только поставить ещё одну «коробку» в стойку. Важно заранее оценить:

- Хватит ли вам мощности по электропитанию с учётом энергопотребления GPU и других ускорителей

- Готова ли система охлаждения выдерживать дополнительную тепловую нагрузку;

- Есть ли физическое пространство в стойках и возможность его расширения;

- нужно ли обновлять сетевую инфраструктуру, чтобы раскрыть потенциал нового оборудования.

UltaAI – интеллектуальный помощник на базе искусственного интеллекта для клиентов UltaHost

UltaAI — это интеллектуальный помощник UltaHost, разработанный для того, чтобы помочь вам мгновенно решать вопросы, связанные с хостингом, доменами, биллингом и техническими проблемами, с помощью умных ответов на основе искусственного интеллекта.

Как понять, нужен ли он вам

AI-сервер даёт серьёзный прирост в вычислительной мощности и контроле, но он точно не нужен «просто так». Прежде чем принимать решение, важно сопоставить:

– реальные и будущие рабочие нагрузки,

– цели, которых вы хотите достичь с помощью ИИ,

– бюджет и готовность инфраструктуры.

Один из самых практичных шагов — честно ответить на несколько базовых вопросов.

Начните с правильных вопросов

Для начала посмотрите на то, как вы уже используете ИИ или планируете использовать его в ближайшее время.

Какова ваша текущая рабочая нагрузка?

- Если вы обучаете или дообучаете модели, вам почти наверняка понадобятся ускорители и память с высокой пропускной способностью, особенно при работе с крупными или кастомными моделями.

- Если основная задача — инференс (обслуживание запросов), ресурсы можно распределять гибче: подойдут компактные локальные AI-серверы или облачные GPU-инстансы, в зависимости от частоты запросов и требований по задержке.

Начните с понимания текущей ситуации

Прежде чем принимать решение, взгляните на то, как именно вы используете ИИ сейчас и какие задачи могут появиться в ближайшее время.

Насколько интенсивна ваша нагрузка?

- Если вы активно обучаете модели или планируете регулярно дообучать их под свои задачи, тогда без ускорителей и памяти с высокой пропускной способностью не обойтись. Особенно если речь идёт о крупных или кастомных моделях.

- Если ваши задачи связаны в основном с инференсом — то есть обработкой запросов, — подходы могут быть гибче: подойдут небольшие локальные AI-сервера или облачные GPU-инстансы. Выбор зависит от того, насколько часто идут запросы и насколько критична задержка.

Какая нагрузка ожидается в будущем?

- Эпизодическое обучение проще и дешевле проводить в облаке. Но если вы предполагаете, что объём вычислений будет расти или станет постоянным, специализированное оборудование обычно окупается быстрее.

Важно ли вам время отклика?

- Все задачи, в которых важна реакция «здесь и сейчас» — например, визуализация, чат-боты поддержки, робототехника — чувствительны к задержкам. В таких ситуациях локальные решения дают ощутимое преимущество.

- Более гибкие или менее критичные процессы, наоборот, можно смело размещать в облаке.

Нужен ли полный контроль над данными?

- Если компания работает с чувствительной информацией, требуются более строгие меры безопасности. В таких случаях локальные или частные AI-серверы становятся предпочтительным вариантом.

Проверьте готовность вашей инфраструктуры

AI-серверы предъявляют повышенные требования к ресурсам, поэтому заранее убедитесь, что:

- Мощности электропитания хватит даже на пик нагрузки

- Система охлаждения справится с тепловыделением

- Есть физическое место для оборудования

- Бюджет покрывает не только покупку, но и обслуживание

- Команда готова управлять такой системой и поддерживать её в рабочем состоянии

Сравните доступные варианты

| Вариант | Лучше всего подходит для | Плюсы | Минусы |

| Стандартный хостинг | Веб-сайты и блоги | Доступность | Не рассчитано на ИИ |

| VPS | Хороший вариант для небольших инструментов, когда нужен больший контроль | Больше контроля и настроек | Для обучения моделей ресурсов обычно недостаточно |

| Выделенный AI-сервер | Идеален для полноценных обучающих задач и стабильного инференса | Дает максимум контроля | Требует больше всего ресурсов на питание, охлаждение и обслуживание |

| Облачный ИИ | Гибкое решение для переменных или краткосрочных нагрузок | Не требует инвестиций в оборудование | Стоимость при высоком трафике может стремительно расти |

Если объём задач сильно плавает, облачные GPU-ресурсы — безопасный и экономичный вариант. Но если вы постоянно выполняете тяжёлые вычисления, долгосрочно выгоднее инвестировать в собственный AI-сервер.

Контрольный список: когда AI-сервер точно нужен.

-

Обратите внимание, если:

-

вы регулярно обучаете или тонко настраиваете модели;

-

ваши сервисы работают в реальном времени и чувствительны к задержкам;

-

стоимость облачных вычислений растёт быстрее, чем вам хотелось бы;

-

вы обязаны защищать конфиденциальные данные и контролировать инфраструктуру;

-

у вас есть возможности организовать питание, охлаждение и мониторинг;

-

вы рассматриваете долгосрочные инвестиции в производительность;ания или предпочитает полный контроль над инфраструктурой.

Возможные риски и нюансы

Если нагрузки лёгкие или нерегулярные, можно переплатить — в таких сценариях облако будет более эффективным. Тем не менее, несмотря на преимущества, AI-серверы могут потребовать:

- значительных инвестиций в оборудование и инфраструктуру;

- регулярного обслуживания и настройки;

- опытной команды для эксплуатации;

- выделенного пространства и хорошей системы охлаждения.

Будущее AI-инфраструктуры

Технологии стремительно развиваются, и в ближайшие годы нас ждут большие изменения:

| Тенденции | Последствия для бизнеса |

| Рост использования edge-AI серверов | Edge-AI становится всё доступнее. Благодаря этому даже небольшие команды могут запускать ИИ-задачи прямо «на месте» — там, где раньше это было технически невозможно или слишком дорого. |

| Гибридное облако и edge-решения | Гибридная модель позволяет обучать системы в облаке, а выполнять инференс локально — в офисе, на производстве или в частной защищённой среде. Такой подход помогает снизить затраты и ускорить обработку данных. |

| Новые инновации | Современные инженерные решения и снижение тепловыделения в дата-центрах делают работу с ИИ более устойчивой. Одновременный запуск тяжёлых AI-нагрузок становится дешевле в эксплуатации и требует меньше энергии. |

| Усовершенствования в сфере устойчивого развития | Улучшения в охлаждении и энергоэффективности дата-центров позволяют выполнять вычисления с меньшим воздействием на окружающую среду. ИИ-нагрузки постепенно становятся менее затратными и более экологичными. |

| Хостинг и управляемые сервисы «AI-ready» | Появляется всё больше провайдеров, которые предлагают полностью готовые управляемые решения для AI Compute. Это заметно снижает порог входа: компании могут начинать работать с ИИ быстрее и без больших первоначальных вложений. |

AI-серверы движутся к более распределённым, энергоэффективным и быстрым архитектурам, что позволит компаниям внедрять ИИ без огромных затрат.

Чеклист: подходит ли вам AI-сервер?

Ответьте на ключевые вопросы:

Соответствие задачам

-

Обучаете ли вы модели?

-

Выполняете ли инференс в крупном масштабе?

-

Нужны ли минимальные задержки или локальная обработка данных?

Оценка масштаба

-

какой объём запросов вы ожидаете — десятки, сотни, тысячи в минуту?

-

насколько тяжёлая у вас модель: большие языковые, модели CV, что-то кастомное?

-

насколько критична задержка: реальное время, почти реальное или пакетная обработка?

Инфраструктура

-

есть ли у вас достаточная мощность, охлаждение и физическое место для оборудования?

-

есть ли сотрудники, которые смогут поддерживать серверную часть?

-

готова ли ваша среда к размещению GPU или других ускорителей?

Бюджет и затраты

-

окупится ли покупка оборудования с учётом электричества, охлаждения и обслуживания?

-

будет ли это дешевле, чем облачные GPU-инстансы при вашей нагрузке?

Готовность к росту

-

сможете ли вы без проблем увеличивать мощности — добавлять GPU, расширять сервер?

-

допускает ли ваша стратегия переход на гибридную архитектуру позже?

-

будет ли модернизация оборудования для вас простой и доступной?

Этот чеклист помогает быстро понять, нужен ли вам собственный AI-сервер и насколько он вообще соответствует вашим задачам, бюджету и планам на будущее. Он не требует глубоких технических знаний — достаточно честно ответить на вопросы и сопоставить их с вашей реальной нагрузкой.

FAQ

Можно ли обойтись обычным сервером для AI-нагрузок?

Да, для небольших или лёгких задач — можно, однако производительность будет ограничена. Стандартным серверам не хватает многих оптимизаций (ускорителей, пропускной способности памяти, I/O), которые критически важны для AI-рабочих нагрузок.

Кому стоит задуматься о собственном AI-сервере?

Тем, кто регулярно выполняет обучение моделей, обрабатывает крупномасштабный инференс (много пользователей или требования низкой задержки), либо развёртывает AI-решения на периферии c особыми требованиями. Небольшие веб-проекты или простые сайты обычно не нуждаются в выделенном AI-сервере.

Чем отличается облачная инфраструктура от собственного AI-сервера?

Облачные вычисления дают гибкость (оплата по мере использования), отсутствие забот об инфраструктуре и быстрый доступ к ресурсам. Собственный AI-сервер обеспечивает больший контроль и может дать долгосрочную экономию при высоких нагрузках, но требует инфраструктуры, первоначальных вложений и операционных расходов.

Насколько велики расходы на питание и инфраструктуру?

Довольно значимы. AI-серверы потребляют гораздо больше энергии и требуют усиленного охлаждения и дополнительного пространства по сравнению с обычными серверами. С ростом AI-ориентированных дата-центров энергопотребление и охлаждение становятся ключевыми факторами.

Не устареет ли оборудование слишком быстро?

Оборудование действительно развивается быстро (новые ускорители, форм-факторы, edge-решения), поэтому важно планировать возможность обновления. Однако фундаментальная роль AI-серверов остаётся прежней — поддержка обучения и инференса. Риск заключается скорее в том, чтобы не застрять на устаревшем оборудовании.