L’indicizzazione del web da parte di crawler delle liste è comunemente nota come spider e bot. Questi programmi scansionano il web alla ricerca di informazioni in modo strutturale, aiutando i motori di ricerca come Google, Bing e altri ad aggiornare i loro indici. Questo raccoglie tutti i dati in modo completo e offre una migliore visibilità al sito web aggiungendo alla tua lista i web crawler adatti.

In questo blog, discuteremo alcuni dei migliori crawler di liste che dovresti considerare, spiegando cosa fanno e perché. Conoscere questi bot ti permetterà di gestire meglio il tuo sito web e la sua presenza nella SERP. Entriamo nei dettagli di ciascuno di essi.

Googlebot

Googlebot è il crawler delle liste che indicizza le pagine web e aggiorna l’indice di una ricerca su Google. Il processo di ottimizzazione per Googlebot si riduce a tre strategie principali:

- Mantieni sempre il tuo sito web sicuro e attivo 24×7 con un VPS protetto da DDoS.

- Assicurati che la pagina web sia mobile-friendly per l’indicizzazione mobile-first di Google.

- Migliora la velocità delle pagine per l’esperienza dell’utente finale e l’efficienza di crawling.

- Assicurati che contenuti di qualità e pertinenti siano disponibili per soddisfare l’intento di ricerca degli utenti di Google.

- Aggiungi il markup dei dati strutturati ai tuoi contenuti per una migliore comprensione da parte di Google.

Concentrando l’attenzione su questi aspetti, le attività possono aumentare la visibilità su Google, migliorando così il loro posizionamento e attirando più traffico organico.

Bingbot

Bingbot è pensato per Bing, motore di ricerca di Microsoft, nonché un web crawler. Indicizza le pagine web per i risultati di ricerca. L’ottimizzazione per Bingbot si focalizza su alcune strategie essenziali elencate di seguito:

- La struttura del sito web dovrebbe essere evidente e organizzata per facilitare il lavoro di Bingbot.

- Usa parole chiavi rilevanti e pertinenti nel flusso del contenuto e nei meta tag.

- Assicura che il sito sia veloce per garantire l’efficienza dello scansionamento e una migliore esperienza dell’utente.

- Genera contenuto di valore, unico e rilevante che mantenga coinvolti gli utenti e li faccia rimanere sul tuo sito.

Queste strategie miglioreranno la visibilità su Bing, espandendo di conseguenza il bacino di utenti, che potrebbe aumentare il traffico al sito web.

DuckDuckBot

DuckDuckGo è un motore di ricerca che supporta principalmente l’anonimato degli utenti. Il bot indicizza tutte le pagine web per restituire successivamente risultati di ricerca imparziali e privati, senza tracciare le attività degli utenti. L’ottimizzazione per DuckDuckBot include:

- Offrire contenuti che non violino la privacy degli utenti e che supportino le politiche di non tracciamento di DuckDuckGo.

- Utilizzare VPS Anonimi per migliorare la sicurezza e la privacy secondo gli standard di DuckDuckGo.

- Assicurati che il tuo sito venga caricato velocemente per migliorare l’UX e lo scansionamento.

- Concentrati su contenuti originali e di valore che siano interessanti per gli utenti attenti alla privacy.

Adottando queste buone pratiche, l’attività acrescerà la propria visibilità su DuckDuckGo e attirerà molti utenti che apprezzano la privacy e le pratiche di ricerca etiche.

Sogou Spider

Sogou Spider è il crawler delle liste della più grande società di ricerca in Cina, Sogou. Questo crawler indicizza le pagine web per fornire risultati di ricerca aggiornati agli utenti di Sogou. L’ottimizzazione di Sogou Spider comprende:

- Assicurarsi che il contenuto sia in caratteri cinesi semplificati per una migliore indicizzazione.

- Per massimizzare l’efficienza dello scansionamento, presta attenzione a migliorare la velocità del sito.

- Segui le linee guida SEO prescritte per aumentare la visibilità dei tuoi contenuti attraverso Sogou.

- I contenuti pertinenti sono considerati di qualità superiore e conformi ai criteri di indicizzazione di Sogou.

Concentrandosi su questi aspetti, le aziende potranno aumentare la loro visibilità con Sogou, se l’estrazione è necessaria per battere il vasto mercato online cinese ed estendere la portata agli utenti di lingua cinese.

Ottieni Risultati Top Con Web Crawler Utilizzando il Nostro Servizio!

Vuoi i migliori web crawler per potenziare il tuo sito? Utilizza i server ottimizzati di UltaHost con velocità Ultraveloci e Configurazioni Preconfigurate. Ospita i Tuoi Siti e Applicazioni Web sul nostro server ottimizzato per i motori di ricerca e attira i web crawler verso di te.

Exabot

Exabot è un crawler di liste del motore di ricerca Exalead. È dotato di funzionalità di ricerca avanzate e di servizi di indicizzazione dei dati, oltre che di altri strumenti associati. Exabot è in grado di effettuare la scansione degli elenchi e di scansionare le pagine web. Queste informazioni vengono poi utilizzate per aggiornare l’indice di ricerca di Exalead, in modo da fornire risultati di ricerca completi ogni volta che un utente desidera qualcosa dal sito web. L’ottimizzazione per Exabot comprende:

- Costruire il tuo sito con una buona navigazione e una gerarchia logica.

- Garantire tempi di caricamento rapidi per migliorare l’esperienza dell’utente e l’efficienza dello scansionamento.

- Fornire contenuti pertinenti e autorevoli che si allineino alle preferenze di ricerca di Exalead.

- Utilizzare meta tag descrittivi e titoli ottimizzati per migliorare l’accuratezza dell’indicizzazione.

Grazie a queste buone pratiche, l’esposizione su Exalead – associata agli utenti che cercano funzionalità di ricerca avanzate – può essere notevolmente migliorata per contribuire a estendere la tua visibilità online ai mercati di ricerca a coda lunga.

MojeekBot

MojeekBot è il crawler delle liste del motore di ricerca privacy-first. Mojeek, che indicizza le pagine del web avendo un occhio di riguardo per gli utenti. Ecco alcune indicazioni significative su MojeekBot:

- Mojeekbot funziona indicizzando le pagine web in modo da fornire agli utenti risultati di ricerca imparziali.

- Dà priorità alla privacy, non tracciando le attività degli utenti e non personalizzando i risultati di ricerca.

- I proprietari dei siti web possono lavorare in modo ottimale per MojeekBot concentrandosi sulla qualità e sulla rilevanza dei contenuti.

- Il markup dei dati strutturati può aiutare un bot come MojeekBot a imparare dai contenuti e a indicizzarli di conseguenza.

- MojeekBot apprezza i siti che si caricano rapidamente e che offrono un’esperienza utente senza interruzioni.

Ottimizzando per MojeekBot, le aziende possono attirare maggiormente i cercatori di ricerche alternative orientate alla privacy, aumentando al contempo le possibilità di posizionarsi sulle pagine dei risultati di Mojeek.

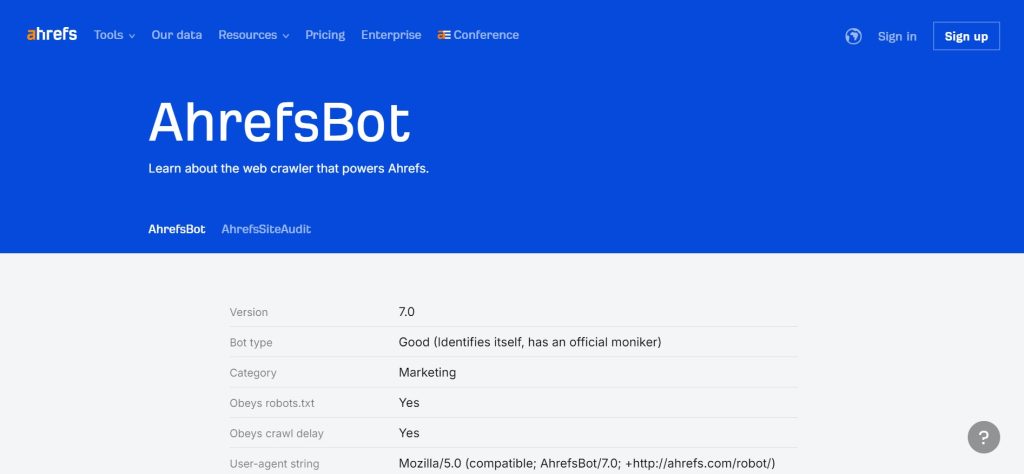

AhrefsBot

AhrefsBot è un crawler delle liste di Ahrefs – uno degli strumenti più utilizzati per l’analisi SEO e il monitoraggio dei backlink. Questo bot scansiona il web per raccogliere dati per l’indice Ahrefs, gestendo approfondimenti su backlink, parole chiave e analisi dei concorrenti. L’ottimizzazione per AhrefsBot comporta:

- Assicurarsi che la struttura del tuo sito web sia pulita e scansionabile.

- Parole chiave e meta tag pertinenti.

- Fornire contenuti autorevoli e di alta qualità che attirino backlink.

- Monitorare e migliorare le metriche di prestazioni del sito.

AhrefsBot è fondamentale per la strategia SEO, in quanto aiuta le aziende a comprendere meglio la loro presenza online e a determinare quali altre strategie potrebbero utilizzare i loro concorrenti. Accettando le preferenze di scansionamento di AhrefsBot, i proprietari di siti web possono provare tutti i mezzi disponibili per aumentare l’ottimizzazione dei loro siti web per i motori di ricerca e incrementare le prestazioni del sito per ottenere informazioni approfondite sui loro sforzi di marketing digitale.

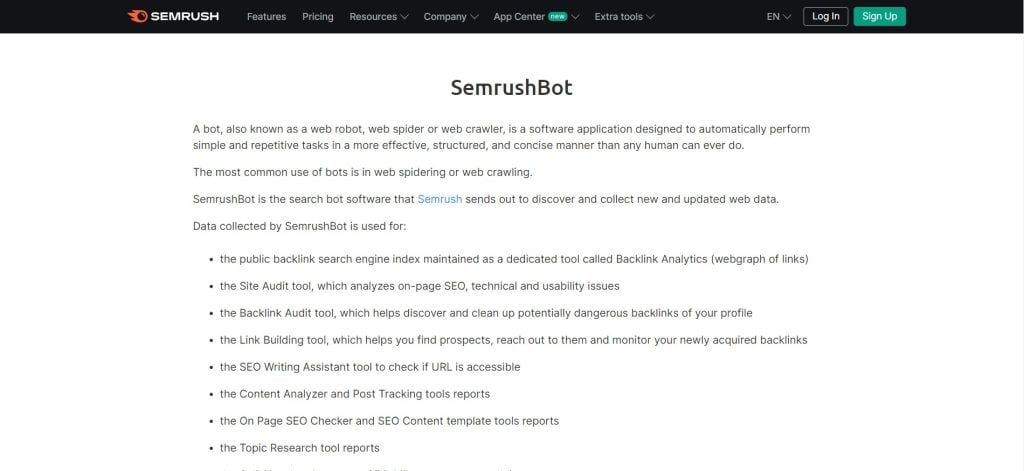

SEMrushBot

SEMrushBot è il crawler delle liste di SEMRush – un ampio set di strumenti per l’analisi SEO e le analisi di marketing digitale. Questo bot effettua la scansione delle pagine web per estrarre i dati per i report e le analisi SEO complete e approfondite di SEMrush. L’ottimizzazione per SEMrushBot comporta:

- Utilizzo dei server Cloudflare per migliorare la sicurezza e le prestazioni del sito web.

- Il tuo sito deve caricarsi velocemente per garantire un’eccellente efficienza di scansionamento e l’esperienza dell’utente.

- Segui le migliori pratiche di Ottimizzazione dei Motori di Ricerca per quanto riguarda i meta tag, i tag di intestazione e l’ottimizzazione delle parole chiave.

- Utilizzo dei backlink di qualità da siti web autorevoli per migliorare l’autorità del dominio.

L’implementazione delle seguenti strategie migliorerà le prestazioni delle attività durante la scalata delle classifiche SEO, come analizzato da SEMrush, e consentirà di trarre preziose indicazioni sui loro sforzi di marketing digitale.

Conclusioni

È possibile posizionare i migliori web crawler in cima al proprio elenco di crawler per ottenere la massima visibilità e velocità rispetto a più o meno tutti i motori di ricerca. Ogni web crawler, da Googlebot a SEMrushBot, ha uno scopo diversificato dietro allo scansionamento, all’indicizzazione, al posizionamento e ad altre funzioni estese o correlate. Sapere cosa fanno e come ottimizzare il tuo sito rispetto a ciascuno di essi fa la differenza nella tua strategia SEO complessiva.

Con un web crawler di alto livello collegato al tuo sito, puoi utilizzare il servizio VPS con RAM Elevata di UltaHost per liberare la velocità, la potenza e le prestazioni di alto livello del tuo sito web. Con il servizio VPS e il web crawler di UltaHost, puoi essere certo di migliorare il traffico e il coinvolgimento del sito.

FAQ

Qual è il miglior web crawler?

Il miglior web crawler dipende da ciò che si vuole fare. Se si tratta di indicizzare le pagine web, allora Googlebot è al primo posto; se invece si tratta di analizzare le metriche SEO, AhrefsBot e SEMrushBot meritano una menzione in cima alla lista.

È illegale fare web-scrape/crawl?

L’uso illegale di un web crawler implica la violazione dei termini di servizio di un sito web, effettuando lo scraping dei suoi dati senza autorizzazione o causando un sovraccarico del server, noto come attacco DDoS. Controlla sempre le politiche di un sito web prima di procedere.

Come ottimizzare un web crawler?

Ottimizzate il tuo web crawler con i tassi di crawl, proteggendo i server dal sovraccarico e impostando regole in robots.txt; questo ti aiuterà a scaricare contenuti rilevanti. Strumenti come Cloudflare sono utili per la sicurezza e le prestazioni.

I web crawler vengono ancora visualizzati?

Un motore di ricerca deve indicizzare i propri contenuti in un web crawler e produrre risultati pertinenti in risposta a una ricerca. Diversi settori industriali li utilizzano anche per l’aggregazione e l’analisi dei dati.

Quanto è veloce il crawler di Google?

In genere, Google indicizza i siti web indicizzabili in un arco di tempo compreso tra 3-4 giorni fino a un paio di settimane.